تحقيقات وتقارير

تقرير: تحديث iOS 11.4 يسبب نفاد بطارية هواتف آيفون بشكل سريع

أطلقت شركة أبل تحديث iOS 11.4 أواخر الشهر الماضى، حيث اشتمل التحديث العديد من الميزات والتغييرات الجديدة، لكنه يعانى من مشكلة خطيرة، حيث اشتكى العديد من المستخدمين من الذين قاموا بتحديث أجهزتهم إلى iOS 11.4 من استنزاف البطارية السريع.

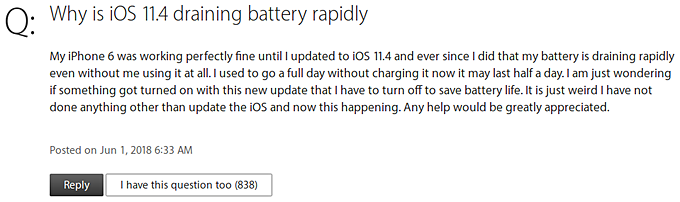

ظهرت هذه الشكاوى على منتدى أبل الرسمى، وكان ضمن هذه المناقشات، واحدة ضمت أكثر من 1000 مستخدم أكدوا على معاناة هواتفهم الذكية من هذه المشكلة.

ويبدو أن المشكلة منفصلة عن نوع إصدار آيفون الذى يستخدمه المستخدمين، حيث إنها موجودة على مختلف الإصدارات، وفيما يتعلق بالحلول البديلة لإيقاف هذه المشكلة، فيمكن إيقاف تشغيل شبكة Wi-Fi فى بعض الحالات، فيما كشف البعض أنهم قاموا بالتراجع لاستخدام iOS 11.3.1 ما جعل عمر البطارية طبيعيًا مرة أخرى، ومن جانبها، لم تقدم Apple بعد أى كلمة رسمية فى هذا الشأن.